生成AIとデータセキュリティの統合ガイド:考慮すべきリスクとその具体的な対策

生成AIはビジネスの変革を促進する一方、企業は新たなデータセキュリティ責任を負うことが求められています。AIチャットボットやアシスタントを通じて送信されるデータは前年比30倍に増加し、情報流出や内部不正といったリスクが急増しています。これに伴い、AI規制も加速しており、データセキュリティはもはやシステム部門だけの問題ではなく、経営課題として捉えられるべきです。本記事では、生成AIとデータの価値、リスク、ガバナンスの必要性を論じ、現代のビジネスにおけるセキュリティ対策の重要性を明らかにします。

プロローグ:生成AIと社会、データセキュリティ新時代

2025年、生成AIはビジネス変革の先端に位置づけられる一方、企業・組織はかつてない重大なデータセキュリティ責任を負うことが求められるようになりました。AIチャットボットやAIアシスタント(Copilot、ChatGPTほか)経由のデータ送信量は前年比30倍に増加し、情報流出や内部不正、AIモデル窃取、著作権・プライバシー侵害といったリスクが急増しています。グローバルでのAI規制(EU AI Act等)も制度要件として加速し、もはや「データセキュリティ」はシステム部門のみならず経営課題そのものです。

本記事では、生成AIとデータの根源的な価値から、固有リスク、一般的/AI特有の技術・運用品質、コンプライアンスや倫理要素、さらに最先端データガバナンス基盤の活用まで、“攻めと守り”、“現場と経営” 双方の観点から総合的に論じます。

生成AIとデータの本質的価値

生成AIの強みは、「多様なデータの収集・学習・生産・再活用力」にあります。大量のテキスト、画像、音声、ビジネス文書、顧客データ、IoTセンサ情報に至るまで、全産業における競争力の源泉となっています。単なる効率化を超え、意思決定の高度化、製品・サービス差別化、組織知の高速循環の実現へと進化しています。

一方で、「どのデータがどこから来て、誰が・どんな目的で・どのように使われるのか」を“見える化”し、リアルタイムで統制・追跡できる体制なくして、AI活用・データ活用の信頼は成立しません。透明性と説明責任こそ、現代データガバナンスとセキュリティの新たな要件です。

生成AIの主要なデータセキュリティリスク

生成AI基盤特有のリスク構造

生成AIのアーキテクチャは「外部API/クラウド経由 + 学習型大規模モデル」という二重構造が前提となります。ユーザーのAIサービス入力データがどこで・どのように保存・学習・再利用されているかを完全に把握することは難しく、業務データや個人情報・知的財産の誤入力から即座に外部漏洩するリスクが顕著です。例えば、ChatGPT等のバグ・設定不備や、マルウェア被害によるAIアカウント情報流出事例も既に多発しています。

また、各部門・現場単位で未承認AIサービスが乱用される「シャドーAI」も課題です。実態把握・統制がないままに機密データが流出するケースが増加しており、ガバナンスギャップは組織全体のリスク耐性劣化につながります。

生成AI特有の具体的リスク項目

以下に、生成AI利用におけるセキュリティ課題について、考慮すべき事項を挙げます。

生成AI利用におけるリスク項目

- 機密情報漏洩

- プロンプトインジェクション等のAI入力攻撃

- データポイズニング、モデル窃取

- 不適切なデータ分類・アクセス権管理

- サプライチェーン・API経由の攻撃

- LLM脆弱性、エージェント権限肥大化

- シャドーAI、内部不正

- マルウェアやディープフェイク、偽情報

- 誤情報のハルシネーション拡散 ほか

一般的データセキュリティと生成AI特有の対策

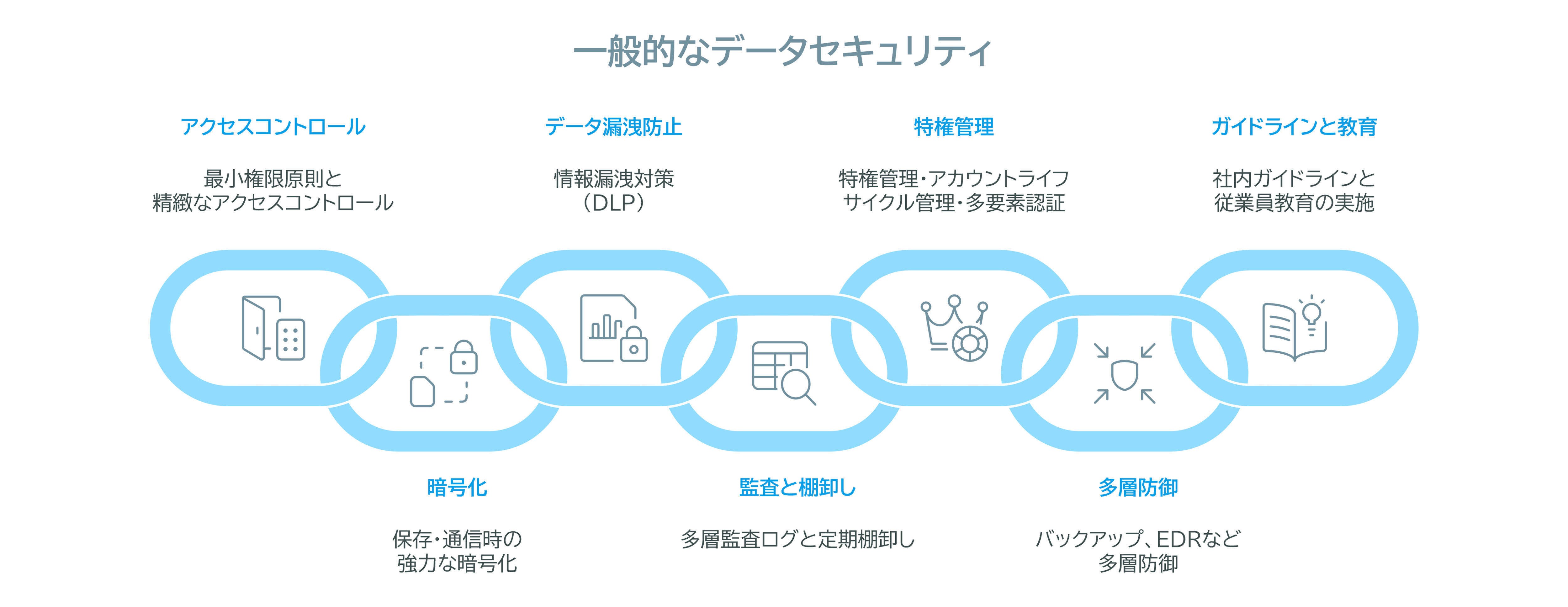

一般的なデータセキュリティ

生成AI時代においても、従来のセキュリティ原則は土台として極めて重要です。データにおけるセキュリティの考慮事項は次の通りです。

データにおけるセキュリティ

- 最小権限原則×精緻なアクセスコントロール

- 保存・通信時の強力な暗号化

- DLP(情報漏洩防止)

- 多層監査ログと定期棚卸し

- 特権管理・アカウントライフサイクル管理・多要素認証

- バックアップ、EDRなど多層防御

- 社内ガイドライン

- 従業員教育体制

これらの「守りの層」を確実に実装することで、AI固有リスクにも対応できる、強固な基盤が生まれます。

生成AI特有のリスク対策

生成AIを活用することで、業務において圧倒的なスピードや業務効率を生み出す一方で、具体的なデータを入力することで、適切な環境で利用をしない場合、データ漏洩などのリスクも高まります。具体的には、次のような対策を講じる必要があります。

- プロンプトインジェクション、システムプロンプト漏洩

AIへの入力内容監査/トリガ検知、ベクトルDB権限管理等 - シャドーAI/サードパーティAI乱用

利用状況の自動検出、利用ポリシー徹底、端末レベルでの統制 - データ事前フィルタリング、履歴監査

データ持ち込み時の匿名化、AI学習設定OFFの徹底(学習対象外設定活用) - 出力監査・再編集体制

生成物の内容精査と二次利用前の人間レビュー - RAG(Retrieval-Augmented Generation)のリスク管理と外部データ引用ルール策定

著作権侵害や誤情報を防ぐ引用ルールの策定、データの正確性と透明性の確保

このように、新たな動的監視(AI特有インシデントへの即応体制)と、ガバナンス整備(社内外ガイドライン・運用規定のアップデート)が不可欠です。

プライバシーと著作権リスク・ガバナンス

プライバシー保護

生成AIには学習・利用データに個人データや機微情報が混入するリスクが顕著です。個人情報保護法やGDPRでは、意図せぬデータ流通も違法とみなされ、AI設計段階から「プライバシー・バイ・デザイン」「事前匿名化・マスキング」「出力データのリダクション」「ログ・監査体制の強化」が必須です。加えて、AIガバナンス担当による見える化と説明性強化が求められます。

著作権対応

AI学習時の無断データ利用・出力物の依拠性問題は、重大な社会・法的リスクとなっています。日本では著作権法30条の4がAI学習目的利用の例外を設けていますが、適用範囲は限定的です。例えば、特定作家への集中学習や商用利用等をするケースでは、明示的な許諾や管理が必須です。社内ガイドラインへの著作権順守明記、商用展開前の法務チェック、AI出力物の人間によるレビューと運用管理が必須です。また、訴訟リスクや契約・規約トラブルの急増から、多層的ガバナンス(チェックリスト運用、法務・弁護士連携等)の現場定着も不可欠です。

AIと著作権の問題については、文化庁よりガイダンスなどが公表されています。

[ 参考 ] AIと著作権について | 文化庁

ガバナンス・説明責任・AI倫理の実装

AIアウトプットに対し、「なぜ(根拠データ)、どんな意図でそうなったか」を説明・追跡できる体制は、もはや“必須条件”です。欧米・カナダなどではAI行動監査やアウトプットトレーサビリティの義務化が進み、「AI活動履歴の記録・高度ログ取得・監査運用」が商品・取引・規制面すべてで競争力の土台となります。

「透明性・説明責任・公平性・プライバシー配慮・安全性」の原則(責任あるAI)は、現場設計・従業員教育・利用規則にも明確に反映させる必要があり、現場レベルでの「攻めと守りのバランス」が今後のカギです。

統合データガバナンス基盤の活用と現場実装

Microsoft Purview等の意義と活用

生成AI活用時代のセキュリティ対策には、「データ分類・可視化・DLP(データ損失防止)・暗号化・権限設計・ログ監査」を統合するプラットフォームが不可欠です。

具体的な製品としては、Microsoft Purviewがあります。Microsoft Purviewは、クラウド/オンプレ/SaaS混在環境下で全データ資産の自動分類・アクセス制御・監査を一元管理でき、AI活用の現場に適合した自動運用を可能にします。

Microsoft PurviewはAIプロンプトごとの動的DLP、クラウド横断のアクセス統制、各業種ユースケースごと(教育・小売・金融・製造等)のセキュリティテンプレート運用、その透明性の高さなど、各種監査や法規制対応も“現場で使える”水準まで自動・統合化が進んでいます。数万ユーザー規模でも、マルチクラウド環境でも、AIセキュリティ運用を省力化しつつ高度化できます。

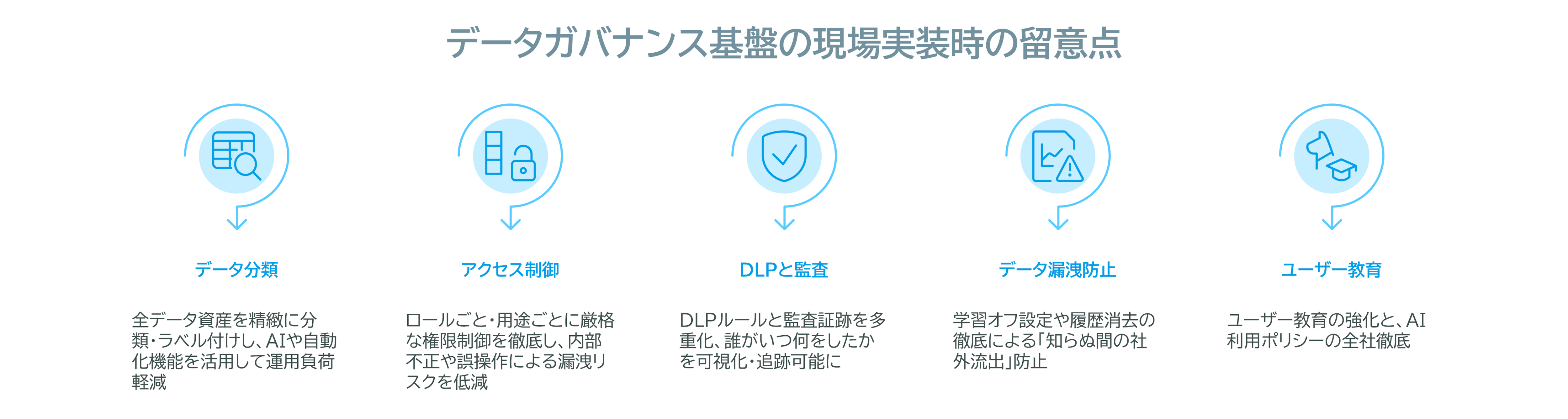

データガバナンス基盤の現場実装時の留意点と未来展望

ガバナンスを実効性高く進めるには、「どのデータがどこにあり、誰が・いつ・どのようにアクセス/使用しているか」の可視化と制御、そして対策運用の標準化が不可欠です。

現場実装時の留意点

- 全データ資産を精緻に分類・ラベル付けし、AIや自動化機能を活用して運用負荷軽減

- ロールごと・用途ごとに厳格な権限制御を徹底し、内部不正や誤操作による漏洩リスクを低減

- DLPルールと監査証跡を多重化、誰がいつ何をしたかを可視化・追跡可能に

- 学習オフ設定や履歴消去の徹底による「知らぬ間の社外流出」防止

- ユーザー教育の強化と、AI利用ポリシーの全社徹底

また、将来は「リアルタイム監査」「自動DLP」「マルチクラウド自動ガバナンス」「AIによる防御・監査・対応支援の統合運用」へと進化していくとされています。AI分野の技術はアップデートが非常に速いですので、常に最新の動向を追って、対策を検討することが必要です。また、そのためには、社内のみならず、社外の専門パートナーとも協業し“仕組み+教育” を段階的・持続的に高めていくといった、ガバナンス構築も有効でしょう。

エピローグ:データセキュリティはAI時代のビジネス持続条件

生成AI時代のデータセキュリティは、「信頼に値する変革=持続可能な強みに直結する経営戦略」となりました。法規制・技術進化・現場課題が激変し続ける今、経営層から現場担当者までが一丸となり「見える化・自動化・教育・ガバナンス」の四重奏で継続改善を図ることが唯一の勝ち筋です。Microsoft Purview等の最先端ソリューションを基盤とした専門的実践力と現場教育が、組織の強靭性・競争優位を根底から支え、安全でしなやかなAI社会を共創しましょう。

JTPでは、これらの生成AI時代のデータセキュリティ対策の導入・運用支援も提供しております。詳しくは、下記のページをご覧いただくか、お気軽にお問合せください。